2024 年我们对大语言模型的认知 [译]

在 2024 年「大语言模型」领域发生了很多事情。以下是过去 12 个月我们在这个领域的发现,以及我对关键主题和重要时刻的总结。

这是对我的 2023 年回顾的续篇。

本文内容:

- GPT-4 的门槛被彻底打破了

- 部分 GPT-4 级别的模型可以在我的笔记本电脑上运行

- 由于竞争和效率提升,LLM 价格大幅下跌

- 多模态视觉能力已经普及,语音和视频也开始涌现

- 语音和实时摄像头模式让科幻成为现实

- 提示词驱动的应用生成已成为一种普遍功能

- 获取最佳模型的普遍机会只持续了短短几个月

- “智能体”还没有真正出现

- 评测真的很重要

- Apple Intelligence 表现不佳,但 Apple 的 MLX 库却很出色

- 推理能力不断提升的”思维”模型的崛起

- 目前最好的 LLM 真的是在中国用不到 600 万美元训练出来的吗?

- 环境影响变好了

- 环境影响变得更糟了

- 垃圾内容横行的一年

- 合成训练数据效果很好

- LLM 的使用变得更加困难了

- 知识分布极不均衡

- LLM 需要更好的批评

- 2024 年我的博客上所有标记为”llms”的文章

GPT-4 的门槛被彻底打破了

在我 2023 年 12 月的回顾中,我写到我们还不知道如何构建 GPT-4—— OpenAI 当时最好的模型已经将近一年了,但其他 AI 实验室还没有产出任何更好的模型。OpenAI 掌握了什么我们不知道的秘密?

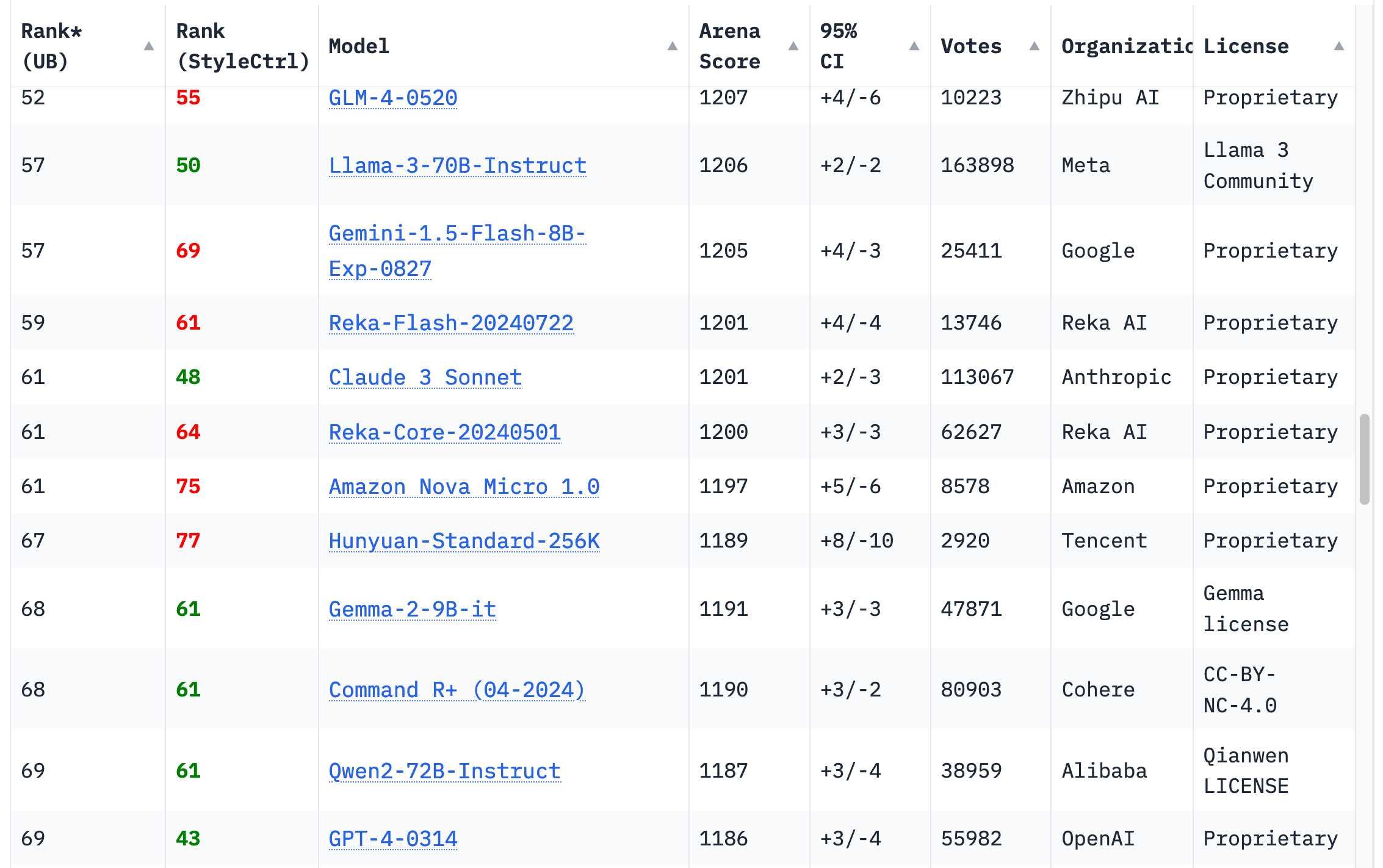

我很欣慰这种情况在过去的 12 个月里已经完全改变了。在Chatbot Arena 排行榜上,现在有 18 个组织的模型排名高于 2023 年 3 月发布的原始 GPT-4(排行榜上显示为「GPT-4-0314」)—— 总共有 70 个模型。

这些模型中最早的是谷歌的 Gemini 1.5 Pro,于 2 月发布。除了能产出 GPT-4 级别的输出外,它还为该领域引入了一些全新的能力 —— 最值得注意的是它的 100 万(后来达到 200 万)token 输入上下文长度,以及处理视频输入的能力。

我当时在Gemini Pro 1.5 的杀手级应用是视频一文中写到了这一点,这让我在 5 月的谷歌 I/O 开场主题演讲中短暂亮相。

Gemini 1.5 Pro 也展示了 2024 年的一个关键主题:上下文长度的增加。去年大多数模型接受 4,096 或 8,192 个 token,值得注意的例外是 Claude 2.1,它接受 200,000 个 token。如今,每个主要的提供商都有 10 万以上 token 的模型,而谷歌的 Gemini 系列最高可接受 200 万 token。

更长的输入极大地扩展了 LLM 可以解决的问题范围:你现在可以输入整本书并询问其内容,但更重要的是,你可以输入大量示例代码来帮助模型正确解决编程问题。涉及长输入的 LLM 用例比纯粹依赖于已经烘焙在模型权重中的信息的短提示更有趣。我的许多工具都是使用这种模式构建的。

说回超越 GPT-4 的模型:Anthropic 的 Claude 3 系列于 3 月推出,Claude 3 Opus 很快成为我新的日常首选。他们在 6 月发布Claude 3.5 Sonnet时再次提升了标准 —— 这个模型在六个月后仍然是我的最爱(虽然它在 10 月 22 日得到了重大升级,但令人困惑的是保持了相同的 3.5 版本号。Anthropic 的粉丝们后来开始称它为 Claude 3.6)。

然后还有其他模型。如果你今天浏览 Chatbot Arena 排行榜 —— 这仍然是基于体感评估模型的最有用的单一平台 —— 你会看到 GPT-4-0314 已经跌至大约第 70 位。排名更高的 18 个组织包括谷歌、OpenAI、阿里巴巴、Anthropic、Meta、Reka AI、01 AI、亚马逊、Cohere、DeepSeek、英伟达、Mistral、NexusFlow、智谱 AI、xAI、AI21 Labs、普林斯顿和腾讯。

训练一个能够击败 GPT-4 的模型在 2023 年是一件大事。到了 2024 年,这已经不是什么特别值得注意的成就了,不过我个人仍然会为每一个加入这个行列的新组织感到欢欣鼓舞。

部分 GPT-4 级别的模型可以在我的笔记本电脑上运行

我现在使用的个人笔记本电脑是 2023 年的 64GB M2 MacBook Pro。这是一台性能强劲的机器,但现在也已经快两年了 —— 关键是这就是我自从 2023 年 3 月第一次在电脑上运行 LLM 以来一直在使用的同一台笔记本电脑(参见大语言模型正在迎来它们的 Stable Diffusion 时刻)。

去年 3 月这台笔记本电脑勉强能运行 GPT-3 级别的模型,现在已经运行过多个 GPT-4 级别的模型了!以下是我的一些笔记:

- Qwen2.5-Coder-32B 是一个能在我的 Mac 上运行且编程能力出色的 LLM —— 11 月关于 Qwen2.5-Coder-32B 的文章,这还是一个 Apache 2.0 许可的模型!

- 我现在可以在笔记本电脑上运行 GPT-4 级别的模型了 —— 讲述了在 12 月运行 Meta 的 Llama 3.3 70B 的经历

这对我来说仍然令人震惊。我原以为具有 GPT-4 功能和输出质量的模型需要一台配备一个或多个 4 万多美元 GPU 的数据中心级服务器。

这些模型会占用我 64GB 内存中的相当大一部分,所以我不经常运行它们 —— 它们不会给其他程序留下太多运行空间。

能运行这些模型本身就证明了我们在过去一年中在训练和推理性能方面取得的惊人进步。事实证明,在模型效率方面还有很多低垂的果实可以采摘。我预计未来还会有更多进展。

Meta 的 Llama 3.2 模型值得特别提及。虽然它们可能不是 GPT-4 级别的,但在 1B 和 3B 规模上,它们的表现远超其体量。我使用免费的 MLC Chat iOS 应用在 iPhone 上运行 Llama 3.2 3B,对于其微小的体积(<2GB)来说,这是一个令人惊讶的强大模型。试着启动它,让它「写一个关于数据记者爱上当地陶艺家的 Netflix 圣诞电影的剧情大纲」。以下是我得到的结果,速度达到了令人满意的每秒 20 个 token:

这是剩余的对话记录。虽然内容平淡老套,但我的手机现在可以为 Netflix 策划平淡老套的圣诞电影了!

由于竞争和效率提升,LLM 价格大幅下跌

过去 12 个月里,顶级托管 LLM 的运行成本出现了显著下降。

在 2023 年 12 月(这里是 OpenAI 定价页面的互联网档案),OpenAI 对 GPT-4 收费 30 美元/百万输入 token,当时新推出的 GPT-4 Turbo 是 10 美元/百万 token,GPT-3.5 Turbo 是 1 美元/百万 token。

如今 30 美元/百万 token 可以让你使用 OpenAI 最贵的模型 o1。GPT-4o 是 2.50 美元(比 GPT-4 便宜 12 倍),GPT-4o mini 是 0.15 美元/百万 token —— 比 GPT-3.5 便宜近 7 倍,而且功能强大得多。

其他模型提供商的收费甚至更低。Anthropic 的 Claude 3 Haiku(3 月发布,但仍是他们最便宜的模型)收费 0.25 美元/百万 token。谷歌的 Gemini 1.5 Flash 是 0.075 美元/百万 token,他们的 Gemini 1.5 Flash 8B 是 0.0375 美元/百万 token —— 这比去年的 GPT-3.5 Turbo 便宜了 27 倍。

我一直在llm-pricing 标签下追踪这些价格变化。

这些价格下跌由两个因素推动:竞争加剧和效率提升。效率提升对于所有关心 LLM 环境影响的人来说都非常重要。这些价格下跌直接反映了运行提示词所需的能源使用量。

关于 AI 数据中心大规模建设的环境影响仍然有很多需要担忧的地方,但是许多关于单个提示词能源成本的担忧已经不再可信。

这里有一个有趣的粗略计算:使用谷歌最便宜的模型 Gemini 1.5 Flash 8B(10 月发布)为我个人照片库中的 68,000 张照片生成简短描述需要多少成本?

每张照片需要 260 个输入 token 和大约 100 个输出 token。

260 * 68,000 = 17,680,000 输入 token 17,680,000 * $0.0375/百万 = $0.66 100 * 68,000 = 6,800,000 输出 token 6,800,000 * $0.15/百万 = $1.02

总成本是 $1.68 用于处理 68,000 张图片。这个价格低得离谱,我不得不计算了三次来确认我没有算错。

这些描述的质量如何?这是我用以下命令得到的结果:

1

llm -m gemini-1.5-flash-8b-latest describe -a IMG_1825.jpeg

针对这张在加州科学院拍摄的蝴蝶照片:

一个浅盘,可能是蜂鸟或蝴蝶喂食器,呈红色。盘中可以看到橙色水果片。

有两只蝴蝶停在喂食器上,一只是深棕色/黑色蝴蝶,带有白色/奶油色的斑纹。另一只是一只大型棕色蝴蝶,带有浅棕色、米色和黑色的花纹,包括显著的眼状斑。较大的棕色蝴蝶似乎正在进食水果。

260 个输入 token,92 个输出 token。成本大约是 0.0024 美分(不到 1 美分的 400 分之一)。

这种效率的提升和价格的下降是 2024 年我最喜欢的趋势。我希望 LLM 的实用性能在能源成本下降的同时得到保持,看起来我们正在实现这一点。

多模态视觉能力已经普及,语音和视频也开始涌现

我上面的蝴蝶示例展示了 2024 年的另一个关键趋势:多模态 LLM 的崛起。

一年前,这类模型最著名的例子是 GPT-4 Vision,在 2023 年 11 月 OpenAI 开发者日上发布。谷歌的多模态 Gemini 1.0 在 2023 年 12 月 7 日宣布,所以它也(勉强)算在 2023 年的范围内。

在 2024 年,几乎每个重要的模型供应商都发布了多模态模型。我们看到了 Anthropic 的 Claude 3 系列在 3 月发布,Gemini 1.5 Pro 在 4 月发布(支持图像、音频和视频),然后 9 月带来了 Qwen2-VL 和 Mistral 的 Pixtral 12B 以及 Meta 的 Llama 3.2 11B 和 90B 视觉模型。我们在 10 月获得了来自 OpenAI 的音频输入和输出功能,然后 11 月看到了来自 Hugging Face 的 SmolVLM,12 月则有来自 Amazon Nova 的图像和视频模型。

10 月,我升级了我的 LLM CLI 工具以支持通过附件使用多模态模型。它现在有了支持多种视觉模型的插件。

我认为那些抱怨 LLM 进展放缓的人往往忽视了这些多模态模型的巨大进步。能够对图像(以及音频和视频)运行提示词是使用这些模型的一种令人着迷的新方式。

提示词驱动的应用生成已成为一种普遍功能

这在 2023 年用 GPT-4 就已经可能实现,但在 2024 年它所提供的价值变得更加明显。

我们已经知道 LLM 在编写代码方面出奇地好。如果你给出正确的提示,它们可以使用 HTML、CSS 和 JavaScript(如果你连接了一些额外的构建机制,还可以使用 React 等工具)为你构建一个完整的交互式应用程序 —— 通常只需要一个提示词。

Anthropic 在发布「Claude Artifacts」这个突破性的新功能时将这个想法推向了一个新的高度,这个功能最初在他们宣布令人惊叹的 Claude 3.5 Sonnet 时被略微忽视了,因为它只在公告的中间部分提到。

通过 Artifacts,Claude 可以为你编写一个按需交互式应用程序,然后让你直接在 Claude 界面内使用它。

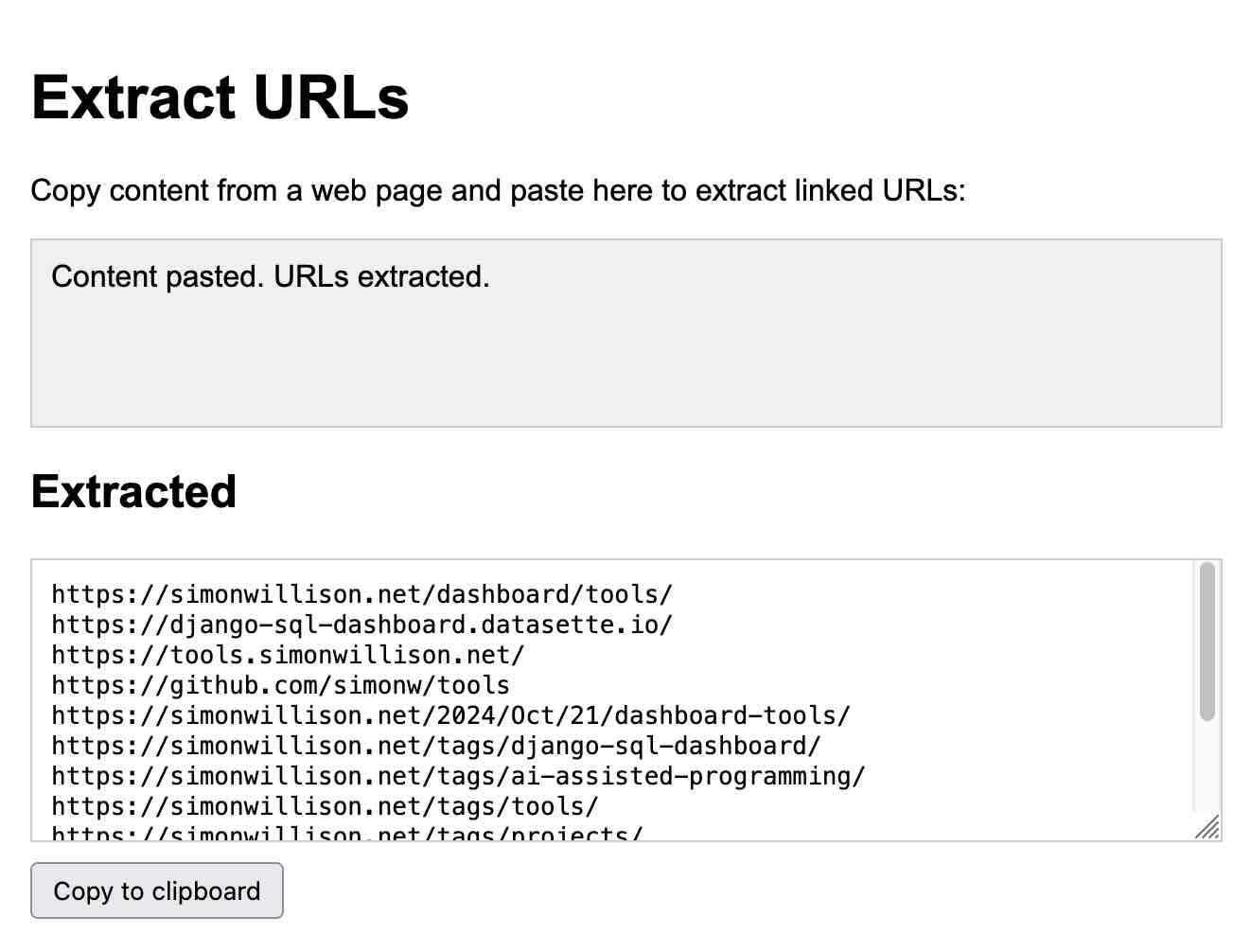

这是我的 Extract URLs 应用,完全由Claude 生成:

我发现自己经常使用这个功能。我在 10 月注意到自己对它的依赖程度,写了本周我用 Claude Artifacts 构建的所有东西,描述了我在七天内制作的 14 个小工具。

从那时起,许多其他团队也构建了类似的系统。GitHub 在 10 月宣布了他们的版本 —— GitHub Spark。Mistral Chat 在 11 月添加了一个名为 Canvas 的功能。

来自 Val Town 的 Steve Krouse 基于 Cerebras 构建了一个版本,展示了一个每秒 2,000 个 token 的 LLM 如何能在不到一秒的时间内迭代应用程序的变更。

然后在 12 月,Chatbot Arena 团队推出了一个全新的排行榜,用户用两个不同的模型构建相同的交互式应用,并对结果进行投票。很难找到比这更有力的证据来说明这个功能现在已经成为可以在所有主流模型上有效实现的一种商品。

我自己也在为我的 Datasette 项目开发这样的功能,目标是让用户能够使用提示词来构建和迭代自己数据的自定义小部件和数据可视化。我还开发出了一种类似的模式,用于编写一次性 Python 程序,由 uv 支持。

这种提示词驱动的自定义界面功能非常强大,而且容易构建(一旦你解决了浏览器沙盒的棘手细节),我预计它会在 2025 年作为一个功能出现在各种产品中。

获取最佳模型的普遍机会只持续了短短几个月

今年有几个月,所有三个最佳模型 —— GPT-4o、Claude 3.5 Sonnet 和 Gemini 1.5 Pro —— 都向世界上大多数地方的用户免费开放。

OpenAI 在 5 月向所有用户免费开放了 GPT-4o,Claude 3.5 Sonnet 从6 月发布起就可以免费使用。这是一个重大的改变,因为在此之前一年里,免费用户主要限制使用 GPT-3.5 级别的模型,这意味着新用户对一个有能力的 LLM 实际能做什么形成了一个非常不准确的心理模型。

这个时代似乎已经结束了,可能是永久性的,随着 OpenAI 推出 ChatGPT Pro。这个每月 200 美元的订阅服务是访问他们最强大的模型 o1 Pro 的唯一方式。

由于 o1 系列(以及它无疑会启发的未来模型)背后的技巧是花费更多的计算时间来获得更好的结果,我认为那些免费访问最佳模型的日子不太可能再回来了。

「智能体」还没有真正出现

我发现”智能体”这个术语非常令人困惑。它缺乏一个单一、清晰且被广泛理解的含义…但使用这个术语的人似乎从不承认这一点。

如果你告诉我你正在构建”智能体”,你几乎没有向我传达任何信息。在不读懂你的想法的情况下,我无法判断你在说的是几十种可能定义中的哪一种。

我看到的两个主要类别是那些认为 AI 智能体显然是代表你行动的东西 —— 旅行社模式 —— 以及那些从被赋予了可以在循环中运行的工具以解决问题的 LLM 角度思考的人。”自主性”这个术语也经常被提及,同样没有包含明确的定义。

(我还在 Twitter 上收集了 211 个定义 —— 这里是Datasette Lite 中的内容 —— 并让 gemini-exp-1206 尝试总结它们。)

无论这个术语可能意味着什么,智能体仍然给人一种永远”即将到来”的感觉。

抛开术语不谈,我仍然对它们的实用性持怀疑态度,这仍然基于轻信性的挑战。LLM 会相信你告诉它们的任何事情。任何试图代表你做出有意义决策的系统都会遇到同样的障碍:如果它无法区分真相和虚构,一个旅行代理、数字助理或者研究工具能有多好呢?

就在前几天,谷歌搜索被发现提供了一个完全虚假的描述,描述了一部不存在的电影”魔法满屋 2”。结果发现是在总结一个粉丝小说维基上的想象电影列表。

提示词注入是这种轻信性的自然结果。我看到 2024 年在解决这个问题上几乎没有进展,而我们从2022 年 9 月就开始讨论这个问题了。

我开始认为”智能体”最流行的想法依赖于 AGI 本身。一个能够抵抗轻信性的模型确实是一个很高的要求。

评测真的很重要

Anthropic 的 Amanda Askell(负责Claude 性格背后的大部分工作)说:

好的系统提示词背后无聊但至关重要的秘密是测试驱动开发。你不是写下一个系统提示词然后找方法测试它。你是写下测试,然后找到一个能通过这些测试的系统提示词。

在 2024 年的过程中,越来越清楚地表明,为基于 LLM 的系统编写好的自动化评测是构建这些模型有用应用的最需要的技能。如果你有一个强大的评测套件,你就能比竞争对手更快地采用新模型,更好地迭代,并构建更可靠和有用的产品功能。

Vercel 的 Malte Ubl 说:

当 @v0 首次推出时,我们对保护提示词非常偏执,用各种预处理和后处理的复杂性。

我们完全改变了方向,放开手脚。没有评测、模型和特别是用户体验的提示词,就像得到一台没有说明书的坏掉的 ASML 机器。

我仍在努力找出自己工作中最佳的实践模式。每个人都知道评测很重要,但是如何最好地实施它们仍然缺乏很好的指导 —— 我在 evals 标签下跟踪这个问题。我的 SVG 鹈鹕骑自行车基准测试与真正的评测套件相比只是一个苍白的模仿。

Apple Intelligence 表现不佳,但 Apple 的 MLX 库却很出色

作为一个 Mac 用户,今年我对我的平台选择感觉好多了。

去年,缺少一台配备 NVIDIA GPU 的 Linux/Windows 机器感觉是尝试新模型时的一个巨大劣势。

理论上,一台 64GB 的 Mac 应该是运行模型的绝佳机器,因为 CPU 和 GPU 可以共享相同的内存。实践中,许多模型以模型权重和库的形式发布,这些库更偏向于 NVIDIA 的 CUDA 而不是其他平台。

llama.cpp 生态系统在这方面帮助很大,但真正的突破是苹果的 MLX 库,”一个用于 Apple Silicon 的数组框架”。它太棒了。

苹果的 mlx-lm Python 支持在我的 Mac 上运行各种 MLX 兼容的模型,性能出色。Hugging Face 上的 mlx-community 提供了超过 1,000 个已转换为必要格式的模型。

Prince Canuma 出色且快速发展的 mlx-vlm 项目也将视觉 LLM 带到了 Apple Silicon 上。我最近用它运行了 Qwen 的 QvQ。

虽然 MLX 是一个游戏规则改变者,但苹果自己的”Apple Intelligence”功能大多令人失望。我在 6 月写了关于他们的初步公告,当时我乐观地认为苹果专注于那些保护用户隐私并最大限度地减少用户被困惑功能误导的 LLM 应用子集。

现在这些功能正在推出,它们相当薄弱。作为一个 LLM 的高级用户,我知道这些模型能做什么,而苹果的 LLM 功能提供的只是前沿 LLM 能力的一个苍白模仿。相反,我们得到的是歪曲新闻标题的通知摘要和我完全没有发现有用的写作助手工具。不过 Genmoji 还挺有趣的。

推理能力不断提升的「思维」模型的崛起

2024 年最后一个季度最有趣的发展是新型 LLM 的出现,以 OpenAI 的 o1 模型为代表 —— 最初作为 o1-preview 和 o1-mini 在 9 月 12 日发布。

理解这些模型的一种方式是将其视为思维链提示的扩展,这个技巧最早在 2022 年 5 月的论文大语言模型是零样本推理器中探索。

这就是那个技巧,如果你让一个模型大声说出它正在解决的问题,你经常会得到一个模型本来无法达到的结果。

o1 将这个过程进一步烘焙到模型本身中。细节有些模糊:o1 模型会花费”推理 token”来思考问题,这些 token 对用户不直接可见(尽管 ChatGPT 界面会显示它们的摘要),然后输出最终结果。

这里最大的创新是它开辟了一种扩展模型的新方式:模型现在可以不仅仅通过在训练时增加计算量来提高性能,还可以通过在推理时花费更多计算来解决更难的问题。

o1 的续作 o3(他们因为欧洲商标原因跳过了”o2”)在 12 月 20 日宣布,在 ARC-AGI 基准测试上取得了令人印象深刻的结果,尽管这可能涉及超过 100 万美元的计算时间成本!

o3 预计将于 1 月推出。我怀疑很少有人有需要这种级别计算支出的实际问题 —— 我当然没有!—— 但它似乎是 LLM 架构在解决更困难问题方面的真正下一步。

OpenAI 在这里并不是唯一的玩家。谷歌在 12 月 19 日发布了他们在这个类别中的第一个参赛者,gemini-2.0-flash-thinking-exp。

阿里巴巴的 Qwen 团队在 11 月 28 日发布了他们的 QwQ 模型 —— 使用 Apache 2.0 许可证,而且我可以在自己的机器上运行它。他们在12 月 24 日又推出了一个名为 QvQ 的视觉推理模型,[我也在本地运行了它](https://simonwillison.net/2024/Dec/DeepSeek 在11 月 20 日通过他们的聊天界面提供了他们的 DeepSeek-R1-Lite-Preview 模型供试用。

要了解更多关于推理扩展的内容,我推荐 Arvind Narayanan 和 Sayash Kapoor 的AI 进展正在放缓吗?。

Anthropic 或 Meta 还没有任何动作,但我会非常惊讶如果他们没有自己的推理扩展模型正在开发中。Meta 在 12 月发布了一篇相关论文训练大语言模型在连续潜空间中进行推理。

目前最好的 LLM 真的是在中国用不到 600 万美元训练出来的吗?

差一点就是了!但这确实是一个引人注目的标题。

年末的重大新闻是 DeepSeek v3 的发布 —— 圣诞节当天在 Hugging Face 上发布,连 README 文件都没有,然后第二天才跟上文档和论文。

DeepSeek v3 是一个巨大的 685B 参数模型 —— 是目前可用的最大的开放许可模型之一,明显大于 Meta 的 Llama 系列中最大的 Llama 3.1 405B。

基准测试表明它与 Claude 3.5 Sonnet 相当。体验基准测试(也就是 Chatbot Arena)目前将其排在第 7 位,仅次于 Gemini 2.0 和 OpenAI 4o/o1 模型。这是迄今为止排名最高的开放许可模型。

DeepSeek v3 最令人印象深刻的是训练成本。该模型训练了 2,788,000 H800 GPU 小时,估计成本为 5,576,000 美元。Llama 3.1 405B 训练了 30,840,000 GPU 小时 —— 是 DeepSeek v3 使用量的 11 倍,而模型的基准测试表现略差。

那些针对中国的美国 GPU 出口限制似乎激发了一些非常有效的训练优化!

我将在这里结束这个长篇分析。这是对 2024 年大语言模型领域令人兴奋的进展的全面回顾。

环境影响变得更好了

模型效率的提升 —— 无论是托管的还是我可以在本地运行的 —— 带来了一个可喜的结果:运行提示词的能源使用量和环境影响在过去几年中已经大幅下降。

OpenAI 本身对比 GPT-3 时代,提示词的收费降低了 100 倍。我有可靠消息称,谷歌 Gemini 和亚马逊 Nova(两个收费最低的模型提供商)运行提示词时并没有亏损。

我认为这意味着,作为个人用户,我们完全不需要为绝大多数提示词消耗的能源感到愧疚。其影响可能比开车上街,甚至看 YouTube 视频的影响都要小。

同样,在训练方面。DeepSeek v3 的训练成本不到 600 万美元,这是一个很好的迹象,表明训练成本可以而且应该继续下降。

对于效率较低的模型,我发现将它们的能源使用与商业航班进行比较很有用。最大的 Llama 3 模型的成本相当于从纽约到伦敦的几架满载客机。这当然不是无关紧要的,但一旦训练完成,这个模型就可以被数百万人使用,而无需额外的训练成本。

环境影响变得更糟了

这里更大的问题是,为未来这些模型设想的必要基础设施的巨大竞争性建设。

谷歌、Meta、微软和亚马逊等公司都在投入数十亿美元建设新的数据中心,这对电网和环境产生了实质性的影响。甚至有人谈论建设新的核电站,但这可能需要几十年时间。

这种基础设施真的有必要吗?DeepSeek v3 的 600 万美元训练成本和 LLM 价格的持续下跌可能暗示它不是必要的。但如果你是大科技公司的高管,你会不会想成为那个主张不建设这种基础设施,结果几年后被证明是错误的人?

这里一个有趣的比较可能是 19 世纪铁路在全球的铺设方式。建设这些铁路需要巨额投资,对环境产生了巨大影响,而且许多铺设的线路最终被证明是不必要的 —— 有时甚至有多家公司的线路服务完全相同的路线!

知识分布极不均衡

大多数人现在都听说过 ChatGPT。但有多少人听说过 Claude?

积极关注这些内容的人与不关注的 99% 的人口之间的知识差距是巨大的。

变化的速度也没有帮助。仅在过去的一个月里,我们看到了可以让你把手机摄像头对准某物并用语音谈论它的实时界面普及,还可以选择让它假装成圣诞老人。大多数自称极客的人甚至都还没有尝试过这个。

考虑到这项技术对社会的持续(和潜在的)影响,我认为这种差距的规模是不健康的。我希望看到更多努力来改善这一点。

LLM 需要更好的批评

很多人对这些东西绝对厌恶。在我经常出没的一些场合(Mastodon、Bluesky、Lobste.rs,甚至偶尔在 Hacker News),仅仅暗示「LLM 是有用的」就足以引发一场大争论。

我理解。有很多理由不喜欢这项技术 —— 环境影响、训练数据的(缺乏)伦理、可靠性的缺失、负面应用、对人们工作的潜在影响。

LLM 绝对值得批评。我们需要讨论这些问题,找到缓解它们的方法,并帮助人们学习如何负责任地使用这些工具,使积极应用超过消极影响。

我喜欢对这些东西持怀疑态度的人。炒作声已经持续震耳欲聋两年多了,而且有大量的蛇油和错误信息。许多非常糟糕的决定都是基于这种炒作。保持批判精神是一种美德。

如果我们希望有决策权的人能够做出关于如何应用这些工具的良好决定,我们首先需要承认确实存在好的应用,然后帮助解释如何将这些付诸实践,同时避免许多不直观的陷阱。

(如果你仍然认为根本没有任何好的应用,我不确定你为什么会读到这篇文章的这个位置!)

我认为告诉人们这整个领域都是环境灾难性的抄袭机器,它们不断编造东西,这是在对那些人做一种不公平。这里确实存在真正的价值,但获取这种价值是不直观的,需要指导。

那些理解这些东西的人有责任帮助其他人弄明白。

2024 年我的博客上所有标记为「llms」的文章

因为我无疑遗漏了很多东西,这里是我在 2024 年写的每一篇被标记为 llms 的长文:

(这个列表是使用用 Django SQL Dashboard 生成的,使用了 Claude 为我写的 SQL 查询。)

原文作者:Simon Willison 原文链接:https://simonwillison.net/2024/Dec/31/llms-in-2024/

![MLC Chat: Llama - [系统] 准备就绪。请给出一个数据记者爱上当地陶艺家的 Netflix 圣诞电影剧情大纲。已开启 Markdown 显示。这里是一个 Netflix 圣诞电影的剧情大纲:标题:「陶泥之恋」剧情大纲:我们的主角 JESSICA 是一位数据记者,她刚刚回到家乡柳溪镇,这是一个坐落在雪山中的迷人小镇。她回来是为了写一篇关于小镇历史和城市化对当地社区影响的报道。](https://static.simonwillison.net/static/2024/mlc-chat-christmas.jpg)